Ik weet dat deze vraag al is beantwoord (en redelijk goed, naar mijn mening), maar er was hier een andere vraag met een opmerking @NRH waarin de grafische uitleg werd genoemd, en in plaats van plaats de afbeeldingen daar, het lijkt passender om ze hier te plaatsen.

Dus, hier gaat het. Het is niet zo cool als een R-pakket. Maar het is op zichzelf staand en vereist geen abonnement op JSTOR.

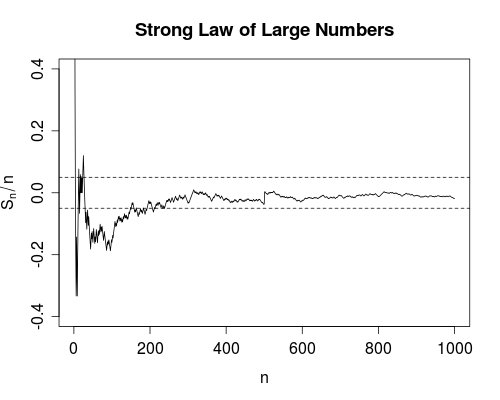

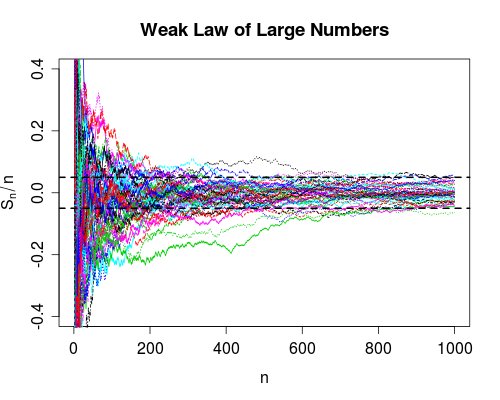

In het volgende hebben we het over een eenvoudige willekeurige wandeling, $ X_ {i} = \ pm 1 $ met dezelfde waarschijnlijkheid, en we berekenen lopende gemiddelden, $$ \ frac {S_ {n}} {n} = \ frac {1} {n} \ sum_ {i = 1} ^ {n} X_ {i}, \ quad n = 1, 2, \ ldots. $$

De SLLN (convergentie vrijwel zeker) zegt dat we 100% zeker kunnen zijn dat deze kromme naar rechts zal uiteindelijk, op een bepaald moment, voor altijd daarna volledig binnen de banden vallen (naar rechts).

De R-code die wordt gebruikt om deze grafiek te genereren staat hieronder (plotlabels zijn weggelaten voor beknoptheid).

n <- 1000; m <- 50; e <- 0,05s <- cumsum (2 * (rbinom (n, size = 1, prob = 0,5) - 0,5)) plot (s / seq.int (n), type = "l", ylim = c (- 0.4, 0.4)) abline (h = c (-e, e), lty = 2)

De WLLN (convergentie in waarschijnlijkheid) zegt dat een groot deel van de voorbeeldpaden zich in de banden aan de rechterkant bevindt, op het moment $ n $ (voor het bovenstaande lijkt het ongeveer 48 of 9 van de 50). We kunnen er nooit zeker van zijn dat een specifieke curve op een eindige tijd binnen zal zijn, maar kijken naar de massa noedels erboven zou een redelijk veilige gok zijn. De WLLN zegt ook dat we het aandeel noedels binnenin zo dicht mogelijk bij 1 kunnen maken als we willen door de plot voldoende breed te maken.

De R-code voor de grafiek volgt (nogmaals, labels overslaan).

x <- matrix (2 * (rbinom (n * m, size = 1, prob = 0,5) - 0,5), ncol = m) y <- toepassen (x, 2, functie (z ) cumsum (z) / seq_along (z)) matplot (y, type = "l", ylim = c (-0.4,0.4)) abline (h = c (-e, e), lty = 2, lwd = 2 )